- 638.50 KB

- 2022-09-01 发布

- 1、本文档由用户上传,淘文库整理发布,可阅读全部内容。

- 2、本文档内容版权归属内容提供方,所产生的收益全部归内容提供方所有。如果您对本文有版权争议,请立即联系网站客服。

- 3、本文档由用户上传,本站不保证质量和数量令人满意,可能有诸多瑕疵,付费之前,请仔细阅读内容确认后进行付费下载。

- 网站客服QQ:403074932

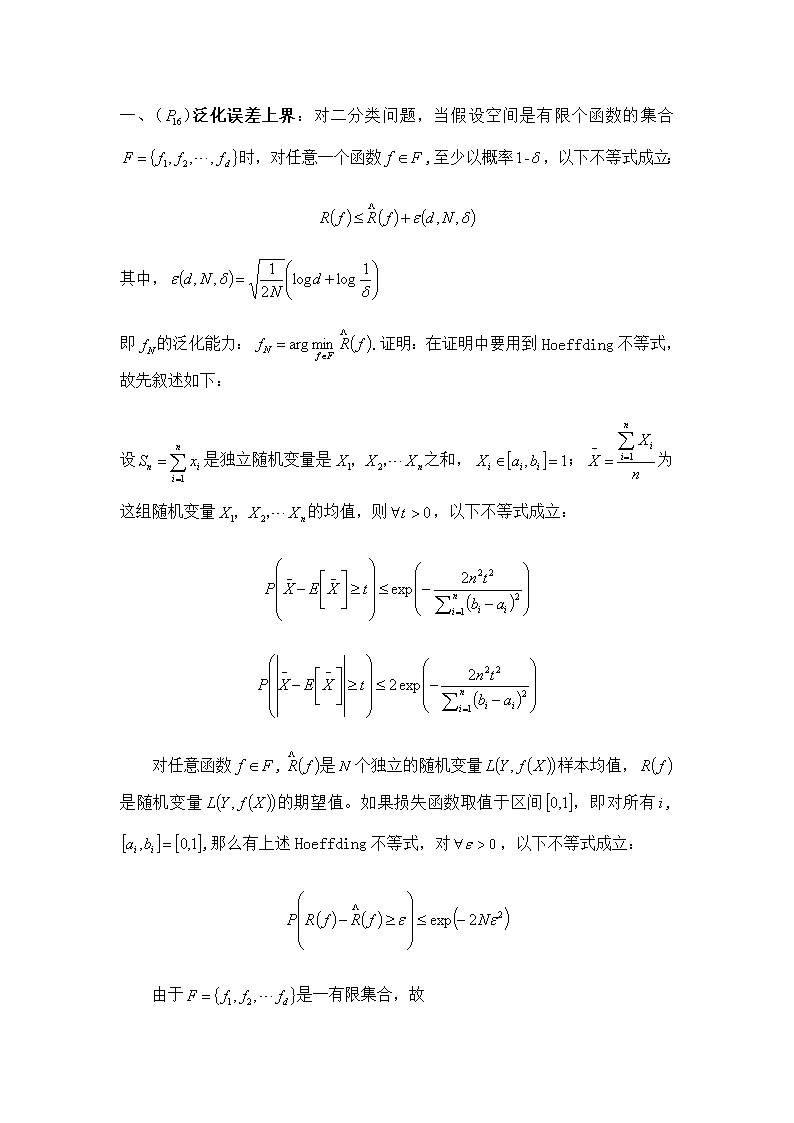

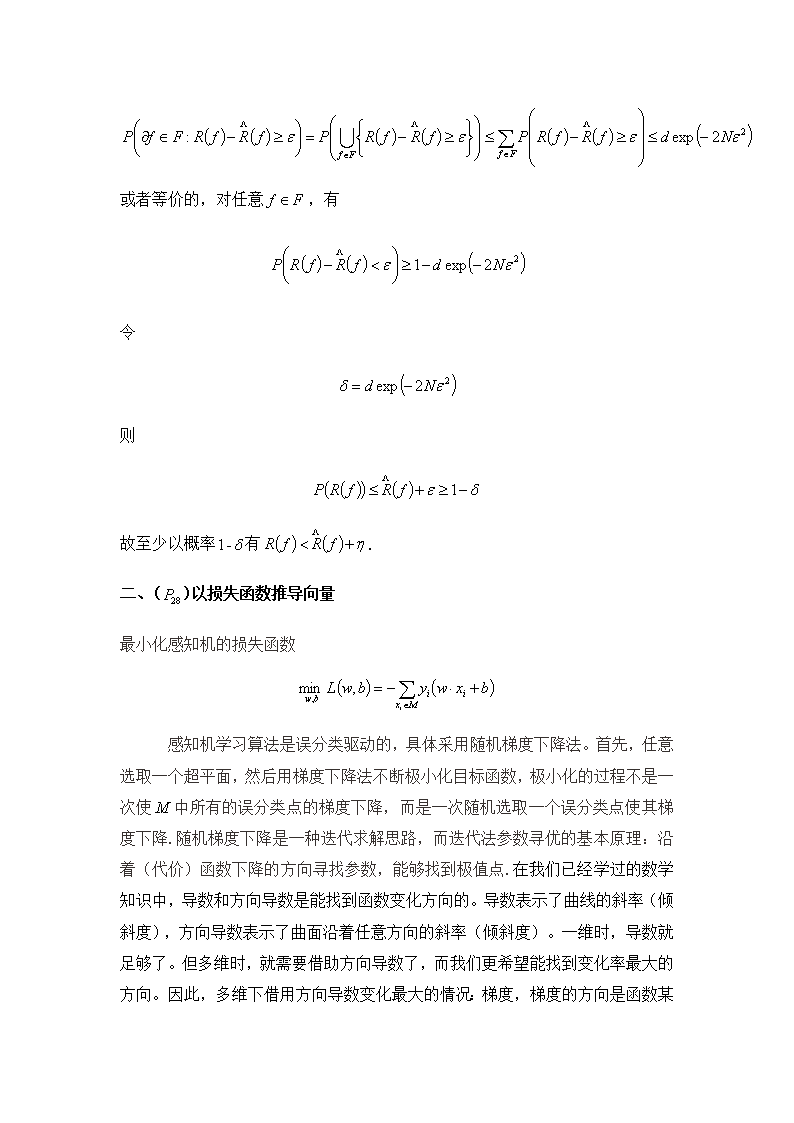

一、()泛化误差上界:对二分类问题,当假设空间是有限个函数的集合时,对任意一个函数,至少以概率,以下不等式成立:其中,即的泛化能力:.证明:在证明中要用到Hoeffding不等式,故先叙述如下:设是独立随机变量是之和,;为这组随机变量的均值,则,以下不等式成立:对任意函数,是个独立的随机变量样本均值,是随机变量的期望值。如果损失函数取值于区间,即对所有,,那么有上述Hoeffding不等式,对,以下不等式成立:由于是一有限集合,故\n或者等价的,对任意,有令则故至少以概率有.二、()以损失函数推导向量最小化感知机的损失函数 感知机学习算法是误分类驱动的,具体采用随机梯度下降法。首先,任意选取一个超平面,然后用梯度下降法不断极小化目标函数,极小化的过程不是一次使中所有的误分类点的梯度下降,而是一次随机选取一个误分类点使其梯度下降.随机梯度下降是一种迭代求解思路,而迭代法参数寻优的基本原理:沿着(代价)函数下降的方向寻找参数,能够找到极值点.\n在我们已经学过的数学知识中,导数和方向导数是能找到函数变化方向的。导数表示了曲线的斜率(倾斜度),方向导数表示了曲面沿着任意方向的斜率(倾斜度)。一维时,导数就足够了。但多维时,就需要借助方向导数了,而我们更希望能找到变化率最大的方向。因此,多维下借用方向导数变化最大的情况:梯度,梯度的方向是函数某点增长最快的方向,梯度的大小是该点的最大变化率.故对于损失函数的梯度是对和求偏导:三、()如图所示的训练数据集,其正实例点是,,负实例点是,试用感知机学习算法的原始形式求感知机模型.这里,,.\n解构建最优化问题:按照感知机学习算法的原始形式,求解,..(1)取初值,(2)对,,未能被正确分类,更新,.,得到线性模型\n(1)对,,显然,,被正确分类,不修改,.对,,被误分类,更新,.,得到线性模型,得到线性模型(5)对,,被误分类,更新,,故得到线性模型(6)对,,被误分类点,更新,.,故得到线性模型(7)对,,被误分类点,更新,.\n,故得到线性模型(7)对,,被误分类点,更新,.,故得到线性模型而该模型对正实例点,,负实例点,都有,则没有分类点,损失函数达到最小.故分离超平面为感知机模型为迭代过程如表\n四、从统计角度考虑哪些因素影响近邻法的准确度.我们知道近邻法是一种应用广泛的非参数分类方法,可用于线性不可分的多类样本识别。它的优点是事先并不要求知道待分样本的分布函数。目前广泛使用的近邻法是以待分类样本为中心做超球体,逐渐扩大超球半径直至超球内包含个已知模式样本为止,判断这个近邻样本中多数属于哪一类,就把待分类样本归为哪一类。分类算法描述如下:假设有个类别,.测试样本和与其最近的样本之间的距离为,,其中的下标表示类,上标表示类个样本中第个样本.在超球半径的前提下,求,表示这个近邻中属于的样本数.上述方法的弱点就是,半径的选取十分困难.值过大,超球体的覆盖面积广,会导致其他类样本被错误的覆盖,从而加大样本的误识率·反之若值过小,则不能完全覆盖该类别中可能的样本点.并且近邻点具有相似的预测值,所以的大小也会影响近邻法的准确度.该方法易受噪声影响,尤其是样本点中孤立点的影响·而我们知道近邻法模型由三个部分构成:距离度量,的值,分类决策规则。所以值的选取也会影响到分类结果.因为值的选取是根据每类样本的数目和分散程度选取的,对不同的应用选取的值也不同·所以我们是要在是在值选定的情况下,对近邻点的搜索区域进行合理的定位,即选取合适的的大小,即全局到局部,同时还要保障分类结果的准确性.具体方法:首先将样本空间的样本点进行小规模有目的性的聚类,聚类后样本空间中样本分布的区域被划分成,若干个半径一定的小超球体·如果能保证超球体内主体类样本数远远大于杂质类样本数,那么搜索时就可根据其条件将搜索范围缩小到某些超球体内,在这些超球体内寻找待分样本点的个近邻点·\n定义代表全体聚类的集合,即中包含全部聚类中的数据·代表确定的近邻点的集合,为最近间隔,为竞争点集,即可能成为近邻点的集合·聚类后计算指定点到每个聚类中心的距离,如图1所示依据这些距离,聚类集被划分,离最近的聚类为,下一个距离较近的聚类为,依次编号·然后将聚类中的所有点添加到中,计算中所有点与的距离,将满足条件的点转移到集合中·这样近邻点的搜索区域就可以被大致定位·求近邻点的关键是确定点到中聚类的搜索距离,为此需创建最近间隔·每次近邻点的搜索范围便是以待分类点为圆心,值为半径的球体.在整个搜索过程中最近间隔一直处在变化过程中,值修改时采用使间隔内包含尽量少的需要计算的近邻点的原则,已确保搜索的准确性·当聚类被初始划分时,由于采用局部聚类的方法,因此可能造成两个聚类存在重叠区域·为避免重叠区域的点因重搜索而影响算法效率,所以在计算最近间隔时,还必须考虑中的聚类是否有重叠区·当最近间隔被初始创建时,检查与其他聚类是否有重叠区域,如果没有且,则中所有点皆放入中,此时.如果有重叠区域或,则·当被确定后,中所有点依据值,将满足条件的点转移到中·若中的点搜索完毕,则按编号将下一个聚类中的点添加到中,重复上述操作,直到中包含个元素时为止.四、根据表2计算:(1)后验概率;(2)离散属性的类条件概率;\n(1)连续属性的类条件概率分布的参数(样本均值和方差)Id有房婚姻状况年收入拖欠贷款1真单身125KNo2否已婚100KNo3否单身70KNo4真已婚120KNo5否离婚95KYes6否已婚60KNo7真离婚220KNo8否单身85KYes9否已婚75KNo10否单身90KYes表2 从该数据集计算得到的先验概率以及每个离散属性的类条件概率、连续属性的类条件概率分布的参数(样本均值和方差)如下:先验概率:P(Yes)=;P(No)=\n年收入:如果类=No:样本均值=;样本方差=2975;如果类=Yes:样本均值=90;样本方差=25待预测记录:={有房=否,婚姻状况=已婚,年收入=120K}由于0.0024大于0,所以该记录分类为。从上面的例子可以看出,如果有一个属性的类条件概率等于0,则整个类的后验概率就等于0。仅仅使用记录比例来估计类条件概率的方法显得太脆弱了,尤其是当训练样例很少而属性数目又很多时。解决该问题的方法是使用m估计方法来估计条件概率\n六、.\n